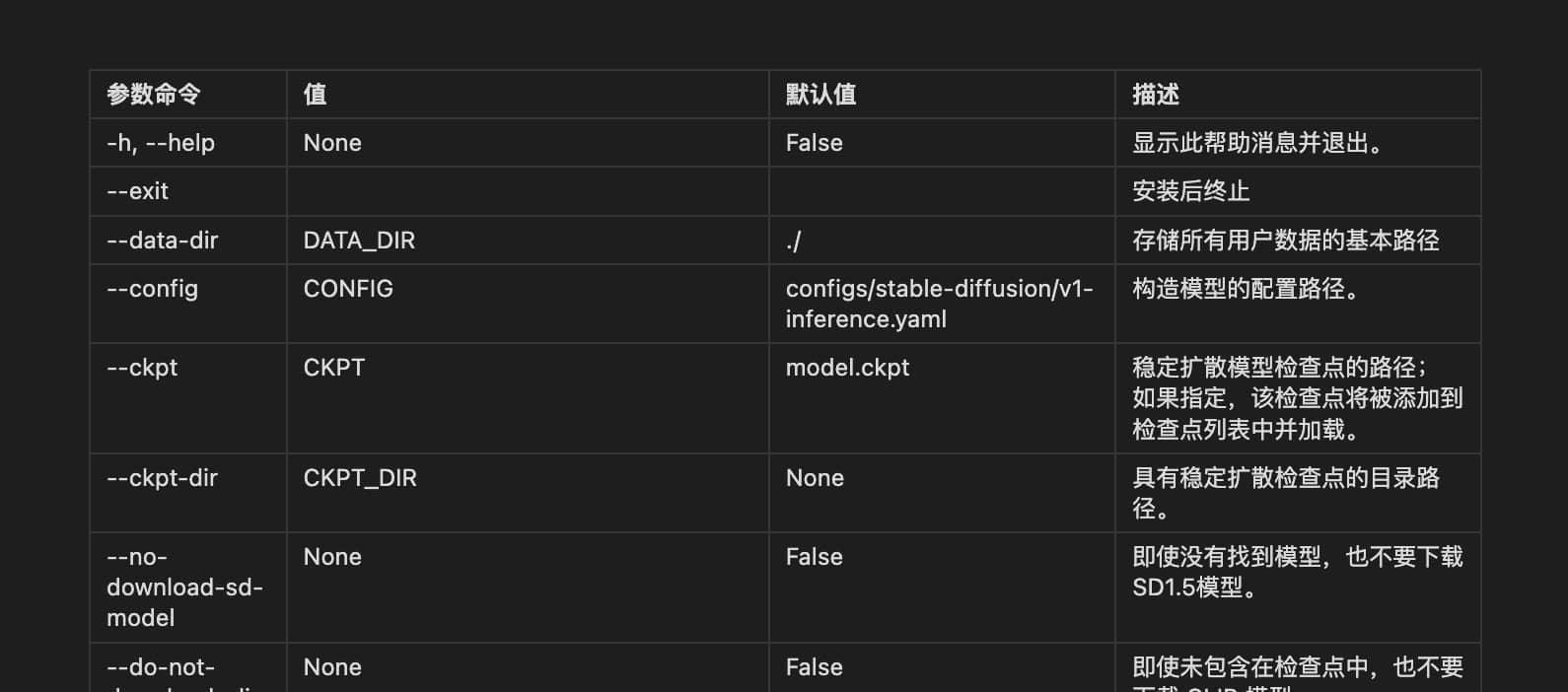

Stable Diffusion命令行参数

| 参数命令 | 值 | 默认值 | 描述 |

|---|---|---|---|

| -h, —help | None | False | 显示此帮助消息并退出。 |

| —exit | 安装后终止 | ||

| —data-dir | DATA_DIR | ./ | 存储所有用户数据的基本路径 |

| —config | CONFIG | configs/stable-diffusion/v1-inference.yaml | 构造模型的配置路径。 |

| —ckpt | CKPT | model.ckpt | 稳定扩散模型检查点的路径; 如果指定,该检查点将被添加到检查点列表中并加载。 |

| —ckpt-dir | CKPT_DIR | None | 具有稳定扩散检查点的目录路径。 |

| —no-download-sd-model | None | False | 即使没有找到模型,也不要下载SD1.5模型。 |

| —do-not-download-clip | None | False | 即使未包含在检查点中,也不要下载 CLIP 模型 |

| —vae-dir | VAE_PATH | None | 变分自动编码器模型的路径 |

| —vae-path | VAE_PATH | None | 用作 VAE 的检查点; 设置这个参数 |

| —gfpgan-dir | GFPGAN_DIR | GFPGAN/ | GFPGAN 目录. |

| —gfpgan-model | GFPGAN_MODEL | GFPGAN model file name. | |

| —codeformer-models-path | CODEFORMER_MODELS_PATH | models/Codeformer/ | 包含 Codeformer 模型文件的目录路径。 |

| —gfpgan-models-path | GFPGAN_MODELS_PATH | models/GFPGAN | 包含 GFPGAN 模型文件的目录路径。 |

| —esrgan-models-path | ESRGAN_MODELS_PATH | models/ESRGAN | 包含 ESRGAN 模型文件的目录路径。 |

| —bsrgan-models-path | BSRGAN_MODELS_PATH | models/BSRGAN | 包含 BSRGAN 模型文件的目录路径。 |

| —realesrgan-models-path | REALESRGAN_MODELS_PATH | models/RealESRGAN | RealESRGAN 模型文件的目录路径。 |

| —scunet-models-path | SCUNET_MODELS_PATH | models/ScuNET | ScuNET 模型文件的目录路径。 |

| —swinir-models-path | SWINIR_MODELS_PATH | models/SwinIR | 包含 SwinIR 和 SwinIR v2 模型文件的目录路径。 |

| —ldsr-models-path | LDSR_MODELS_PATH | models/LDSR | 包含 LDSR 模型文件的目录路径。 |

| —lora-dir | LORA_DIR | models/Lora | Lora 网络目录的路径。 |

| —clip-models-path | CLIP_MODELS_PATH | None | 包含 CLIP 模型文件的目录路径。 |

| —embeddings-dir | EMBEDDINGS_DIR | embeddings/ | 用于文本反转的嵌入目录(默认值:嵌入)。 |

| —textual-inversion-templates-dir | TEXTUAL_INVERSION_TEMPLATES_DIR | textual_inversion_templates | 带有文本反转模板的目录。 |

| —hypernetwork-dir | HYPERNETWORK_DIR | models/hypernetworks/ | 超网络目录。 |

| —localizations-dir | LOCALIZATIONS_DIR | localizations/ | 本地化目录。 |

| —styles-file | STYLES_FILE | styles.csv | 用于样式的文件名。 |

| —ui-config-file | UI_CONFIG_FILE | ui-config.json | 用于 UI 配置的文件名。 |

| —no-progressbar-hiding | None | False | 不要在 gradio UI 中隐藏进度条(我们隐藏它是因为如果浏览器中有硬件加速,它会减慢 ML 速度)。 |

| —max-batch-count | MAX_BATCH_COUNT | 16 | UI 的最大批次计数值。 |

| —ui-settings-file | UI_SETTINGS_FILE | config.json | 用于 UI 设置的文件名。 |

| —allow-code | None | False | 允许从 Web UI 执行自定义脚本。 |

| —share | None | False | 对 gradio 使用 share=True 并使 UI 可通过其网站访问。 |

| —listen | None | False | 使用 0.0.0.0 作为服务器名称启动 gradio,允许响应网络请求。 |

| —port | PORT | 7860 | 使用给定的服务器端口启动 gradio,您需要端口 < 1024 的 root/admin 权限; 如果可用,默认为 7860。 |

| —hide-ui-dir-config | None | False | 从 Web UI 隐藏目录配置。 |

| —freeze-settings | None | False | 禁用编辑设置 |

| —enable-insecure-extension-access | None | False | 无论其他选项如何,都启用扩展选项卡。 |

| —gradio-debug | None | False | 使用 —debug 选项启动 gradio。 |

| —gradio-auth | GRADIO_AUTH | None | 设置 gradio 身份验证,如用户名:密码; 或用逗号分隔多个,如 u1:p1,u2:p2,u3:p3。 |

| —gradio-auth-path | GRADIO_AUTH_PATH | None | 设置gradio认证文件路径ex。 /path/to/auth/file 与 —gradio-auth 相同的身份验证格式。 |

| —disable-console-progressbars | None | False | 不要将进度条输出到控制台。 |

| —enable-console-prompts | None | False | 使用 txt2img 和 img2img 生成时将提示打印到控制台。 |

| —api | None | False | 使用 API 启动 Web UI。 |

| —api-auth | API_AUTH | None | 设置 API 的身份验证,例如用户名:密码; 或用逗号分隔多个,如 u1:p1,u2:p2,u3:p3。 |

| —api-log | None | False | 启用所有 API 请求的日志记录。 |

| —nowebui | None | False | 只启动 API,不启动 UI。 |

| —ui-debug-mode | None | False | 不要加载模型来快速启动 UI。 |

| —device-id | DEVICE_ID | None | 选择要使用的默认 CUDA 设备(之前可能需要导出 CUDA_VISIBLE_DEVICES=0,1 等)。 |

| —administrator | None | False | 管理员权限。 |

| —cors-allow-origins | CORS_ALLOW_ORIGINS | None | 允许的 CORS 来源采用逗号分隔列表的形式(无空格)。 |

| —cors-allow-origins-regex | CORS_ALLOW_ORIGINS_REGEX | None | 允许采用单个正则表达式形式的 CORS 来源。 |

| —tls-keyfile | TLS_KEYFILE | None | 部分启用 TLS,需要 —tls-certfile 才能完全运行。 |

| —tls-certfile | TLS_CERTFILE | None | 部分启用 TLS,需要 —tls-keyfile 才能完全发挥作用。 |

| —disable-tls-verify | None | False | 通过后,即可使用自签名证书。 |

| —server-name | SERVER_NAME | None | 设置服务器的主机名。 |

| —no-gradio-queue | None | False | 禁用渐变队列; 导致网页使用http请求而不是websocket; 是早期版本中的默认值。 |

| —gradio-allowed-path | None | None | 添加Gradio的allowed_paths路径; 使得可以从中提供文件。 |

| —no-hashing | None | False | 禁用检查点的 SHA-256 哈希以帮助加载性能。 |

| —skip-version-check | None | False | 不要检查 torch 和 xformers 的版本。 |

| —skip-python-version-check | None | False | 不检查 Python 的版本。 |

| —skip-torch-cuda-test | None | False | 不检查CUDA是否能够正常工作。 |

| —skip-install | None | False | 跳过软件包的安装。 |

| —loglevel | None | None | 日志级别; 以下之一:严重、错误、警告、信息、调试 |

| —log-startup | None | False | launch.py 参数:打印启动时发生的情况的详细日志 |

| —api-server-stop | None | False | 通过 api 启用服务器 stop/restart/kill |

| —timeout-keep-alive | int | 30 | 为 uvicorn 设置 timeout_keep_alive |

| 参数命令 | 值 | 默认值 | 描述 |

|---|---|---|---|

| —xformers | None | False | 为交叉注意力层启用 xformers。 |

| —force-enable-xformers | None | False | 为交叉注意层启用 xformers,无论检查代码是否认为您可以运行它; 如果这不起作用,请不要报告错误。 |

| —xformers-flash-attention | None | False | 启用带有 Flash Attention 的 xformers 以提高再现性(仅支持 SD2.x 或变体)。 |

| —opt-sdp-attention | None | False | 启用缩放点积交叉注意层优化; 需要 PyTorch 2.* |

| —opt-sdp-no-mem-attention | False | None | 启用缩放点积交叉注意力层优化,无需内存高效注意力,使图像生成具有确定性; 需要 PyTorch 2.* |

| —opt-split-attention | None | False | 强制启用 Doggettx 的交叉注意力层优化。 默认情况下,它在启用 CUDA 的系统上处于打开状态。 |

| —opt-split-attention-invokeai | None | False | 强制启用 InvokeAI 的交叉注意力层优化。 默认情况下,当 CUDA 不可用时它会打开。 |

| —opt-split-attention-v1 | None | False | 启用旧版本的分割注意力优化,不会消耗所有可用的 VRAM。 |

| —opt-sub-quad-attention | None | False | 实现内存高效的次二次交叉注意力层优化。 |

| —sub-quad-q-chunk-size | SUB_QUAD_Q_CHUNK_SIZE | 1024 | 用于次二次交叉注意力层优化的查询块大小。 |

| —sub-quad-kv-chunk-size | SUB_QUAD_KV_CHUNK_SIZE | None | 用于次二次交叉注意力层优化的 KV 块大小。 |

| —sub-quad-chunk-threshold | SUB_QUAD_CHUNK_THRESHOLD | None | 使用分块进行次二次交叉注意力层优化的 VRAM 阈值的百分比。 |

| —opt-channelslast | None | False | 启用 4d 张量的替代布局,可能会导致仅在具有 Tensor 核心(16xx 及更高)的 Nvidia 卡上更快的推理。 |

| —disable-opt-split-attention | None | False | 强制禁用交叉注意力层优化。 |

| —disable-nan-check | None | False | 不检查生成的图像/潜在空间是否有 nan; 对于在 CI 中没有检查点的情况下运行很有用。 |

| —use-cpu | {all, sd, interrogate, gfpgan, bsrgan, esrgan, scunet, codeformer} | None | 使用CPU作为指定模块的torch设备。 |

| —no-half | None | False | 不要将模型切换为 16 位浮点数。 |

| —precision | {full,autocast} | autocast | 以此精度进行评估。 |

| —no-half-vae | None | False | 不要将 VAE 模型切换为 16 位浮点数。 |

| —upcast-sampling | None | False | 向上采样。 —no-half 没有效果。 通常会产生与 —no-half 类似的结果,并且使用更少的内存,但性能更好。 |

| —medvram | None | False | 启用稳定扩散模型优化,以牺牲一些性能来降低 VRAM 使用率。 |

| —medvram-sdxl | None | False | 仅针对 SDXL 模型启用 —medvram 优化 |

| —lowvram | None | False | 启用稳定扩散模型优化,以牺牲大量速度以获得非常低的 VRAM 使用率。 |

| —lowram | None | False | 将稳定扩散检查点权重加载到 VRAM 而不是 RAM。 |

| —disable-model-loading-ram-optimization | None | False | 禁用加载模型时减少 RAM 使用的优化 |

| 参数命令 | 值 | 默认值 | 描述 |

|---|---|---|---|

| —autolaunch | None | False | 启动时在系统默认浏览器中打开 Web UI URL。 |

| —theme | None | Unset | 打开具有指定主题(浅色或深色)的 Web UI。 如果未指定,则使用默认浏览器主题。 |

| —use-textbox-seed | None | False | 在 UI 中使用种子文本框(无向上/向下,但可以输入长种子)。 |

| —disable-safe-unpickle | None | False | 禁用检查 PyTorch 模型是否存在恶意代码。 |

| —ngrok | NGROK | None | ngrok authtoken,gradio —share 的替代品。 |

| —ngrok-region | NGROK_REGION | us | ngrok 应该启动的区域。 |

| —update-check | None | None | 启动时,通知您的 Web UI 版本(提交)是否与当前主分支保持同步。 |

| —update-all-extensions | None | None | 启动时,它会提取您已安装的所有扩展的最新更新。 |

| —reinstall-xformers | None | False | 强制重新安装 xformers。 对于升级很有用 - 但升级后将其删除,否则您将永久重新安装 xformers。 |

| —reinstall-torch | None | False | 强制重新torch。 对于升级很有用 - 但升级后将其删除,否则您将永久重新安装 torch。 |

| —tests | TESTS | False | 运行测试以验证 Web UI 功能,请参阅 wiki 主题了解更多详细信息。 |

| —no-tests | None | False | 即使指定了 —tests 选项,也不运行测试。 |

| —dump-sysinfo | None | False | launch.py 参数:将有限的 sysinfo 文件(没有有关扩展、选项的信息)转储到磁盘并退出 |

| —disable-all-extensions | None | False | 禁用所有非内置扩展运行 |

| —disable-extra-extensions | None | False | 禁用所有扩展程序运行 |

| 参数命令 | 值 | 默认值 | 描述 |

|---|---|---|---|

| —show-negative-prompt | None | False | 不再有效果。 |

| —deepdanbooru | None | False | 不再有效果。 |

| —unload-gfpgan | None | False | 不再有效果。 |

| —gradio-img2img-tool | GRADIO_IMG2IMG_TOOL | None | 不再有效果。 |

| —gradio-inpaint-tool | GRADIO_INPAINT_TOOL | None | 不再有效果。 |

| —gradio-queue | None | False | 不再有效果。 |

| —add-stop-route | None | False | 不再有效果。 |

| —always-batch-cond-uncond | None | False | 不再有效果。进入“设置”>“优化”下的 UI |

- 感谢你赐予我前进的力量

赞赏者名单

因为你们的支持让我意识到写文章的价值🙏

本文是原创文章,采用 CC BY-NC-SA 4.0 协议,完整转载请注明来自 Nanbowan!

评论

匿名评论

隐私政策

✅ 你无需删除空行,直接评论以获取最佳展示效果